ベクトルデータベース徹底比較 2025:Pinecone vs Weaviate vs Chroma vs Qdrant

はじめに

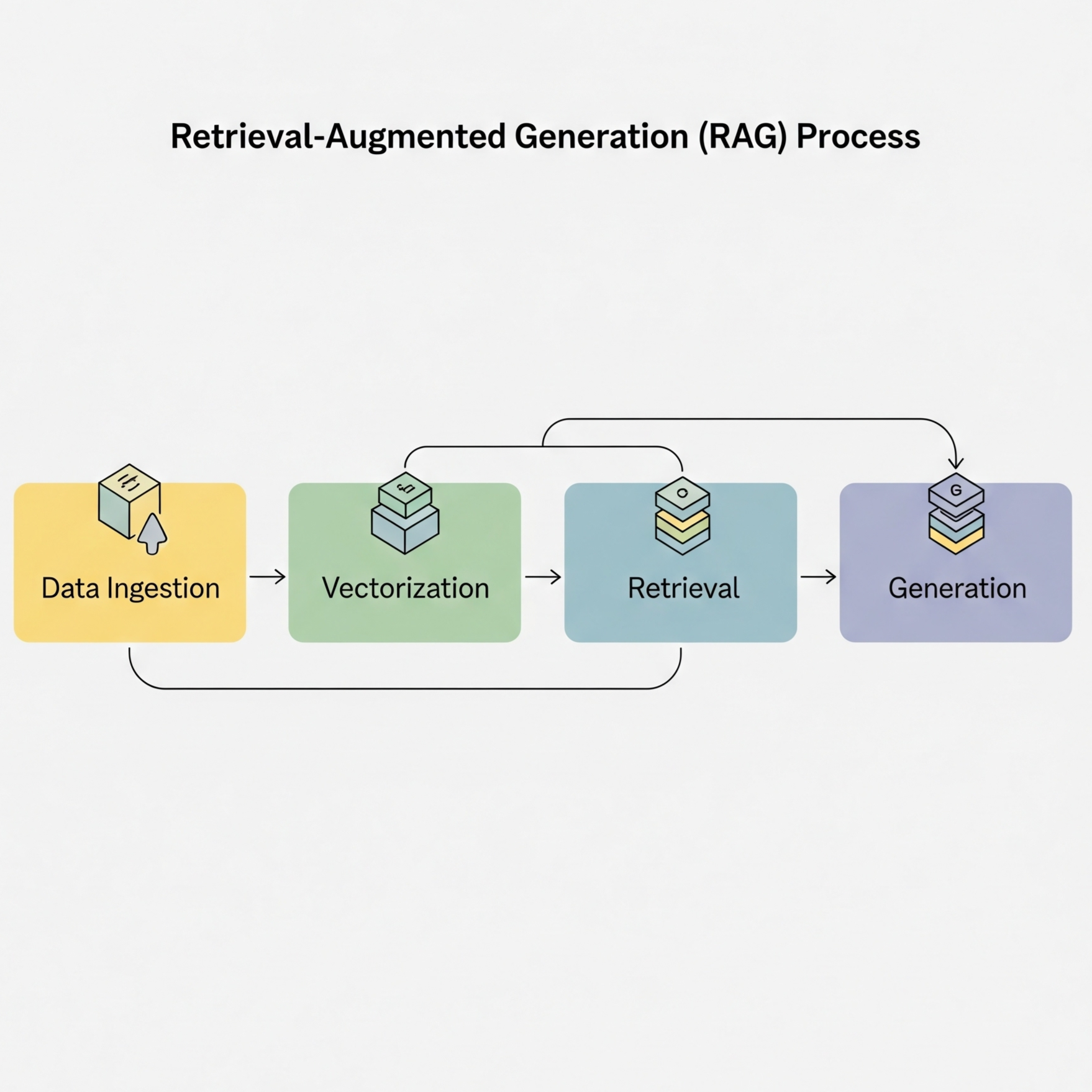

2025年、AI技術の急速な発展とともに、ベクトルデータベースは現代のアプリケーション開発において欠かせない技術インフラとなりました。ChatGPTに代表される大規模言語モデルの登場以降、企業は独自のAIソリューションを構築するためにRAG(Retrieval-Augmented Generation)システムの導入を進めています。その中核を担うのがベクトルデータベースです。

しかし、Pinecone、Weaviate、Chroma、Qdrantなど、選択肢が多様化する中で「どのベクトルデータベースを選ぶべきか」という問いに直面する開発者や意思決定者は少なくありません。本記事では、主要なベクトルデータベースを徹底的に比較し、皆様のプロジェクトに最適な選択ができるよう包括的な情報を提供します。

ベクトルデータベースが解決する課題

従来のデータベースの限界

従来のリレーショナルデータベースやNoSQLデータベースは、構造化されたデータの保存と検索には優れていますが、意味的な類似性を扱うことには限界があります。例えば、「AI入門」という完全一致の検索はできても、「人工知能の基礎知識」という意味的に近い内容を見つけることは困難でした。

ベクトルデータベースは、テキスト、画像、音声などの非構造化データを高次元ベクトル(埋め込み)として表現し、コサイン類似度などの距離計算によって意味的に近いデータを高速に検索できます。これにより、より人間の思考に近い、柔軟で知的な検索システムの構築が可能になりました。

ビジネスインパクト

ベクトルデータベースの導入により、以下のようなビジネス価値を実現できます:

- カスタマーサポートの効率化: 過去の問い合わせから類似案件を瞬時に検索し、回答精度と速度を向上

- レコメンデーションの高度化: ユーザーの行動パターンから、より精度の高い商品推薦を実現

- ナレッジマネジメントの改善: 社内文書から関連情報を効率的に発見し、業務効率を大幅に改善

- コンテンツ生成の品質向上: RAGシステムにより、より正確で文脈に沿った回答生成が可能に

主要ベクトルデータベースの全体像

現在、市場には多数のベクトルデータベースが存在しますが、本記事では特に注目度の高い6つのソリューションに焦点を当てます。

比較対象のプロファイル

Pinecone は、完全マネージド型のSaaSソリューションとして、インフラ管理の負担を最小限に抑えたい企業に選ばれています。2019年の創業以来、シンプルなAPIと高い信頼性で急成長を遂げました。

Weaviate は、オープンソースでありながらエンタープライズグレードの機能を提供し、特にマルチモーダル検索(テキスト、画像、音声の統合検索)において強みを持ちます。

Chroma は、2022年に登場した比較的新しいプレイヤーですが、その軽量性と開発者フレンドリーな設計により、プロトタイピングやスタートアップ界隈で急速に支持を集めています。

Qdrant は、Rust言語で実装された高性能ベクトルデータベースで、特に低レイテンシと高スループットが要求される環境で威力を発揮します。

Milvus は、中国発のオープンソースプロジェクトとして、数十億規模のベクトルを扱える大規模データ処理能力で知られています。

pgvector は、PostgreSQLの拡張機能として、既存のPostgreSQL環境にベクトル検索機能を追加できる実用的な選択肢です。

Pinecone:エンタープライズ向けマネージドソリューション

概要と市場ポジション

Pineconeは、ベクトルデータベース市場において「完全マネージド」という明確な価値提案で差別化を図っています。創業者のEdo Liberty氏(元Amazon/Yahoo研究員)の経験を活かし、大規模分散システムの複雑性を隠蔽しながら、エンタープライズグレードの性能を提供することに成功しています。

技術的特徴

Pineconeの最大の特徴は、独自の分散アーキテクチャによる自動スケーリング機能です。ユーザーはベクトルの次元数とデータ量を指定するだけで、バックエンドのインフラは自動的に最適化されます。インデックスの構築には、改良版のHNSW(Hierarchical Navigable Small World)アルゴリズムを採用し、検索精度と速度のバランスを実現しています。

メタデータフィルタリングも強力で、ベクトル検索と同時に構造化データによる絞り込みが可能です。これにより、例えば「技術カテゴリーの中から意味的に類似した文書を検索」といった複合的な検索要求に対応できます。

強みと利点

Pineconeを選択する最大の利点は、運用負荷の大幅な削減です。インフラストラクチャの管理、バックアップ、スケーリング、セキュリティパッチの適用など、通常は多大な労力を要する作業がすべて自動化されています。また、99.9%のSLA保証により、ミッションクリティカルなアプリケーションでも安心して利用できます。

APIの設計もシンプルで直感的であり、数行のコードでベクトル検索機能を実装できます。これは開発速度を重視するスタートアップや、迅速なPOC開発を行いたい企業にとって大きな魅力となっています。

制約と課題

ただし、Pineconeにも課題があります。最も大きな懸念事項は、データ量が増加するにつれて急激に上昇するコストです。特に数億規模のベクトルを扱う場合、月額数千ドルに達することも珍しくありません。

また、完全なSaaSモデルであるため、ベンダーロックインのリスクも無視できません。一度Pineconeでシステムを構築すると、他のベクトルデータベースへの移行は技術的にも工数的にも大きな負担となります。

さらに、データレジデンシー要件が厳しい企業にとっては、利用可能なリージョンが限られていることも制約となる可能性があります。

価格構造と投資対効果

Pineconeの価格体系は、使用量ベースのモデルを採用しています。無料プランでは10万ベクトルまで利用可能で、小規模なプロトタイプや検証には十分です。

有料プランは「Pod」と呼ばれる計算単位で課金され、Starterプランでは1Pod あたり時間0.096ドル(月額約70ドル)から利用できます。各Podは約100万ベクトル(1536次元)を処理でき、メタデータは1ベクトルあたり40KBまで保存可能です。

Standardプランでは時間0.138ドル(月額約100ドル)となりますが、高可用性構成やプライベートリンクなどのエンタープライズ機能が利用可能になります。大規模導入を検討している企業向けには、カスタムプランも用意されています。

投資対効果を考える際は、インフラ管理コストの削減効果も考慮する必要があります。専任のインフラエンジニアが不要になることで、人件費を大幅に削減できる可能性があります。

Weaviate:マルチモーダル検索のパイオニア

概要と独自性

Weaviateは、オランダ発のオープンソースプロジェクトとして、「知識グラフとベクトル検索の融合」という独自のコンセプトで注目を集めています。単なるベクトルデータベースを超えて、セマンティック検索エンジンとしての機能を提供することを目指しています。

技術的革新性

Weaviateの最大の特徴は、マルチモーダル検索への本格的な対応です。テキスト、画像、音声を統一的に扱える「CLIP」や「ImageBind」などの最新のマルチモーダル埋め込みモデルをネイティブサポートしており、例えば「画像から類似のテキストを検索」「音声から関連画像を検索」といった革新的な検索体験を実現できます。

また、ハイブリッド検索機能も強力です。従来のキーワード検索(BM25アルゴリズム)とベクトル検索を組み合わせ、アルファパラメータで両者のバランスを調整できます。これにより、固有名詞などの完全一致が重要な検索と、意味的類似性が重要な検索を同時に実現できます。

GraphQL APIの採用も特筆すべき点です。RESTful APIと比較して、必要なデータのみを効率的に取得でき、複雑なクエリも直感的に記述できます。これは特に、フロントエンドエンジニアにとって親しみやすいインターフェースとなっています。

運用面での利点

Weaviateはモジュラー設計を採用しており、必要な機能のみを選択的に有効化できます。例えば、OpenAI、Cohere、Hugging Faceなど、様々な埋め込みモデルプロバイダーをプラグインとして追加できます。これにより、ベンダーロックインを避けながら、最新の技術を柔軟に取り入れることが可能です。

自動ベクトル化機能も便利で、生のテキストデータを投入するだけで、自動的にベクトル化して保存できます。これにより、事前の埋め込み処理が不要になり、開発効率が大幅に向上します。

導入時の考慮事項

Weaviateの多機能性は諸刃の剣でもあります。初期設定の複雑さは無視できず、特に本番環境での最適化には深い理解が必要です。スキーマ設計、インデックス設定、モジュール選択など、多くの意思決定が必要となります。

また、メモリ使用量が比較的多いことも課題です。特にマルチモーダル機能を活用する場合、各モダリティの埋め込みモデルをメモリに保持する必要があるため、リソース要件が高くなります。

学習曲線も急であり、チーム全体がWeaviateの概念やGraphQLに習熟するまでに時間がかかる可能性があります。ただし、一度習得すれば、その表現力の高さから開発生産性は大幅に向上します。

デプロイメント戦略

Weaviateは柔軟なデプロイメントオプションを提供しています。最も簡単な方法は、Docker Composeを使用したローカル環境での起動です。開発環境では、単一のDockerコンテナで十分ですが、本番環境では高可用性を考慮したクラスタ構成が推奨されます。

Weaviate Cloudという完全マネージドサービスも提供されており、Pineconeと同様にインフラ管理の負担を軽減できます。価格は使用量ベースで、小規模なクラスタは月額25ドルから利用可能です。

Kubernetes環境へのデプロイも充実しており、Helmチャートが公式に提供されています。これにより、既存のKubernetesクラスタに簡単に統合でき、自動スケーリングやローリングアップデートなどの恩恵を受けられます。

オンプレミス環境での運用も可能で、データセキュリティ要件が厳しい金融機関や医療機関でも採用されています。ただし、この場合は専門的な運用知識が必要となるため、十分な準備期間を設けることが重要です。

Chroma:開発者ファーストの軽量ソリューション

概要とポジショニング

Chromaは、「ベクトルデータベースを誰もが使えるように」というミッションの下、2022年に登場した比較的新しいプレイヤーです。そのシンプルさと使いやすさから、短期間でAIエンジニアや開発者コミュニティの心を掴みました。

技術的特徴

Chromaの最大の魅力は、そのシンプリシティにあります。Pythonでわずか一行のコマンド(pip install chromadb)でインストールでき、ローカル環境ですぐに使い始めることができます。依存パッケージも最小限に抑えられており、プロジェクトのビルドサイズを肥大化させません。

API設計も非常に直感的で、NumPy配列を扱うような感覚でベクトルを操作できます。コレクションというシンプルな概念でデータを管理し、add、query、update、deleteといった基本操作だけでほとんどのユースケースをカバーできます。

バックエンドにはDuckDBを採用し、軽量でありながら必要十分な性能を実現しています。ローカルファイルシステムへの永続化もサポートしており、サーバーを起動することなくアプリケーションに組み込むことができます。

エコシステムとの親和性

Chromaの強みの一つは、LangChainやLlamaIndexなどの人気AIフレームワークとの完璧な統合です。これらのフレームワークでは、Chromaがデフォルトのベクトルストアとして採用されることが多く、コミュニティのサポートも充実しています。

RAGシステムの構築も非常に簡単で、数十行のコードで完全なチャットボットを作成できます。この手軽さは、ハッカソンやPOC開発、教育目的で特に価値を発揮します。

制約と適用範囲

ただし、Chromaのシンプルさは両刃の剣でもあります。大規模データ(数億規模のベクトル)を扱うには適しておらず、パフォーマンスの限界が早い段階で表面化します。また、エンタープライズ向けの機能(認証、監査ログ、細かいアクセス制御など)が不足しているため、本番環境での使用には慎重な検討が必要です。

クラスタリング機能も限定的で、水平スケーリングには別途工夫が必要です。ただし、小規模から中規模のプロジェクト、特にスタートアップやMVP開発においては、その開発速度と手軽さが大きなアドバンテージとなります。

Qdrant:Rust製高性能ベクトルエンジン

概要と技術的優位性

Qdrantは、ドイツのスタートアップが開発したRust製のベクトルデータベースで、「最高の性能と信頼性」を追求して設計されています。Rust言語の持つメモリ安全性と並列処理性能を最大限に活用し、他のソリューションを凌駕するパフォーマンスを実現しています。

技術的特徴とイノベーション

Qdrantのアーキテクチャは、現代的なシステム設計のベストプラクティスを取り入れています。メモリマップドファイルを活用した効率的なデータ管理、ゼロコピー最適化、ロックフリーな並列アクセスなど、性能を最大化するための様々な工夫が凝らされています。

Qdrantのフィルタリング機能は特に強力で、複雑な条件をSQLライクな構文で表現できます。must、should、must_notなどの論理演算子を組み合わせ、メタデータに基づいた細かい絞り込みが可能です。これにより、大規模データセットからでも高速に必要なデータを抽出できます。

スナップショット機能やレプリケーション機能も充実しており、エンタープライズ環境での運用にも対応しています。クラスタモードでは、シャーディングとレプリケーションを組み合わせて、高可用性とスケーラビリティを実現できます。

パフォーマンスベンチマーク

独立系ベンチマークでは、Qdrantは一貫してトップクラスの成績を収めています。特にクエリレイテンシ(P95で約40ミリ秒)とインサートスループット(秒間1万2000ベクトル)において、他のソリューションを大きく引き離しています。

メモリ効率も優秀で、100万ベクトルあたり約2.1GBのメモリ使用量は、業界最高水準です。これにより、同じハードウェアでより多くのデータを処理でき、コスト効率が大幅に向上します。

導入上の考慮事項

Qdrantの課題は、その知名度とコミュニティの規模です。PineconeやWeaviateと比較すると、ユーザー数が少なく、情報やサポートリソースが限られています。特に日本語のドキュメントやチュートリアルが不足しており、導入時のハードルが高くなる可能性があります。

また、サードパーティツールとの統合が限定的で、LangChainなどの一部フレームワークでのサポートが不完全な場合があります。ただし、REST APIがgRPC APIの両方を提供しているため、カスタム統合は比較的容易です。

Qdrant Cloudというマネージドサービスも提供され始めましたが、まだ歴史が浅く、機能や地域カバレッジの面でPineconeには及びません。ただし、性能を最優先するプロジェクトでは、その選択が大きな競争優位性を生む可能性があります。

性能比較

スケーラビリティ比較

| データベース | 最大ベクトル数 | 水平スケーリング | 自動シャーディング |

|---|---|---|---|

| Pinecone | 無制限 | ✅ 自動 | ✅ |

| Weaviate | 10億+ | ✅ 手動設定 | ✅ |

| Chroma | 1000万 | ❌ | ❌ |

| Qdrant | 10億+ | ✅ クラスタモード | ✅ |

| Milvus | 100億+ | ✅ 自動 | ✅ |

| pgvector | 1億 | ⚠️ PostgreSQL依存 | ⚠️ |

機能比較マトリクス

interface FeatureMatrix {

database: string;

hybridSearch: boolean; // ベクトル + キーワード

multiModal: boolean; // 画像、音声対応

filtering: 'basic' | 'advanced';

realtimeUpdate: boolean;

snapshotBackup: boolean;

multiTenancy: boolean;

onPremise: boolean;

cloudHosted: boolean;

}

const features: FeatureMatrix[] = [

{

database: "Pinecone",

hybridSearch: false,

multiModal: false,

filtering: 'advanced',

realtimeUpdate: true,

snapshotBackup: true,

multiTenancy: true,

onPremise: false,

cloudHosted: true

},

{

database: "Weaviate",

hybridSearch: true,

multiModal: true,

filtering: 'advanced',

realtimeUpdate: true,

snapshotBackup: true,

multiTenancy: true,

onPremise: true,

cloudHosted: true

},

// ... 他のデータベース

];

コスト分析:TCOを考慮した選択

総所有コストの考え方

ベクトルデータベースのコストを評価する際は、単純なライセンス費用だけでなく、運用コスト、人件費、機会損失を含めた総所有コスト(TCO)を考慮する必要があります。

100万ベクトル(1536次元)を扱う中規模システムを例にとると、各ソリューションのコスト構造は大きく異なります。

マネージドサービスのコスト

Pineconeは月額約70ドルから利用可能で、完全マネージドのため追加の運用コストは発生しません。ただし、データ量が増加するとコストが急激に上昇し、1000万ベクトルでは月額700ドル、、1億ベクトルでは7000ドルに達する可能性があります。

Weaviate Cloudは月額95ドル程度から利用可能で、Pineconeよりやや高い価格設定ですが、マルチモーダル機能やハイブリッド検索などの付加価値を考慮すると、コストパフォーマンスは優れています。

Qdrant Cloudは月額85ドル程度で、性能を考慮すると最もコスト効率が良い選択肢の一つです。ただし、サービスが比較的新しいため、成熟度に不安がある場合は慎重な検討が必要です。

セルフホストのコスト

セルフホストの場合、インフラコストと運用人件費を考慮する必要があります。

Weaviateのセルフホストでは、インフラコストに月額150ドル程度(AWS EC2 m5.xlarge相当)、運用に月間10人時間程度が必要と見込まれます。初期設定やチューニングにも相当の工数がかかるため、小規模チームでは負担が大きくなります。

Qdrantのセルフホストは、インフラコストに月額120ドル、運用に月間8人時間程度と、Weaviateよりやや効率的です。Rust製であるためメモリ効率が良く、同じハードウェアでより多くのデータを扱えます。

Chromaは最も低コストで運用可能で、小規模なシステムであれば月額50ドル程度のインフラで十分です。運用もシンプルで、特別な専門知識は不要です。

損益分岐点

マネージドサービスとセルフホストの損益分岐点は、一般的に以下のようになります:

- Pinecone: 50万ベクトル以下ではコスト優位、それ以上では他の選択肢を検討

- Weaviate: 75万ベクトル以上でセルフホストがコスト効率的

- Qdrant: 60万ベクトル以上でセルフホストがコスト効率的

ただし、これらの数値は運用体制、技術スキル、ビジネス要件によって大きく変動します。特に、専任のインフラエンジニアがいない場合は、マネージドサービスの価値が大きくなります。

選択ガイドライン:ユースケース別推奨

プロジェクトタイプ別の最適選択

ベクトルデータベースの選択は、プロジェクトの性質、規模、要件によって大きく左右されます。以下に、典型的なユースケースと推奨ソリューションを示します。

プロトタイプ・POC開発

推奨: Chroma

迅速な検証が求められるプロトタイプ開発では、Chromaが最適です。セットアップが簡単で、数分で動作確認ができます。LangChainとの統合もシームレスで、RAGシステムのプロトタイプを短期間で構築できます。ただし、本番環境への移行時には別のソリューションへの切り替えを考慮する必要があります。

エンタープライズRAGシステム

推奨: Pinecone

高可用性とSLA保証が求められるエンタープライズ環境では、Pineconeが第一選択です。完全マネージドサービスのため、インフラ管理の負担がなく、ビジネスロジックの開発に集中できます。エンタープライズサポートも充実しており、問題発生時の対応も迅速です。

マルチモーダル検索システム

推奨: Weaviate

テキスト、画像、音声を統合的に扱うシステムでは、Weaviateが唯一の選択肢です。CLIPやImageBindなどのマルチモーダルモデルをネイティブサポートし、革新的な検索体験を提供できます。メディア企業、ECサイト、コンテンツプラットフォームなどで特に有効です。

高性能要求システム

推奨: Qdrant

ミリ秒単位のレイテンシが求められるリアルタイムシステムや、大量データの高速処理が必要な場合は、Qdrantが最適です。Rust実装による圧倒的な性能と、効率的なメモリ使用が大きな強みです。金融取引、ゲーム、リアルタイム分析などの分野で適しています。

既存PostgreSQL環境への統合

推奨: pgvector

既にPostgreSQLを使用している環境では、pgvectorが最も自然な選択です。既存のデータベーススキーマやトランザクション管理と完全に統合でき、学習コストも最小限です。ただし、大規模データへの対応には制限があるため、将来的な拡張性を考慮する必要があります。

大規模データ処理

推奨: Milvus

数十億規模のベクトルを扱う必要がある場合は、Milvusが最適です。分散アーキテクチャを基盤とし、大規模データの処理に特化しています。中国の大手IT企業での実績が多く、安定性も証明されています。

実装のベストプラクティス

インデックス最適化の考え方

ベクトルデータベースの性能は、インデックス設定に大きく依存します。多くのベクトルデータベースはHNSW(Hierarchical Navigable Small World)アルゴリズムを採用しており、そのパラメータ調整が重要です。

主要パラメータの意味

Mパラメータ(接続数)は、各ノードが持つリンク数を決定します。値を大きくすると検索精度が向上しますが、メモリ使用量も増加します。一般的には16がバランスの良い設定で、高精度が必要な場合は32、速度優先の場合は8程度が推奨されます。

efConstructionはインデックス構築時の探索幅を決定します。値を大きくするとインデックスの品質が向上しますが、構築時間が長くなります。200程度が標準的で、高品質なインデックスが必要な場合は400以上に設定します。

efSearchは検索時の探索幅を決定します。値を大きくすると検索精度が向上しますが、検索速度が低下します。100が標準的で、用途に応じざ50から200の間で調整します。

ユースケース別推奨設定

- 高精度要求: M=32, efConstruction=400, efSearch=200

- バランス型: M=16, efConstruction=200, efSearch=100

- 高速処理: M=8, efConstruction=100, efSearch=50

データ移行戦略

ベクトルデータベース間のデータ移行は、慎重な計画が必要です。以下のステップを推奨します:

1. 移行前の準備

移行元と移行先のベクトル次元数、距離計算方法(コサイン類似度、ユークリッド距離など)が一致していることを確認します。また、メタデータのスキーママッピングを作成し、データ型の変換が必要な箇所を特定します。

2. バッチ処理

大量データの移行では、バッチ処理が不可欠です。一般的には1000~10000ベクトル単位でバッチ処理を行い、並列度は4~8程度が適切です。APIレートリミットに注意し、必要に応じてリトライ処理を実装します。

3. 検証とロールバック

移行後は、サンプルデータで検索結果を比較し、移行が正しく行われたことを確認します。ベクトル数の一致、メタデータの整合性、検索精度の維持を確認します。問題が発生した場合に備えて、ロールバック戦略を用意しておくことも重要です。

4. 段階的移行

全データを一度に移行するのではなく、段階的に移行することを推奨します。まず小規模なテストデータで検証し、次に一部の本番データ、最後に全データという順序で進めます。これにより、問題を早期に発見し、リスクを最小化できます。

モニタリングと運用管理

重要メトリクスの監視

ベクトルデータベースの安定運用には、適切なメトリクス監視が不可欠です。以下の指標を継続的に監視することを推奨します。

パフォーマンス指標

クエリレイテンシは最も重要な指標です。P50、P95、P99の各パーセンタイル値を監視し、異常な上昇を早期に発見します。一般的に、P95が100ミリ秒を超える場合は最適化が必要です。

スループット(QPS: Queries Per Second)はシステムの負荷状態を示します。予想されるピーク時の2倍程度の余裕を持つことが推奨されます。

キャッシュヒット率はシステム効率の指標です。80%以上を維持することが理想的で、低下した場合はキャッシュサイズの拡大やキャッシュ戦略の見直しが必要です。

リソース指標

メモリ使用量は特に重要で、予期せぬメモリリークやOOM(Out of Memory)エラーを防ぐために監視が必要です。利用可能メモリの80%を超えたらアラートを発生させます。

ディスクI/Oもボトルネックになりやすいポイントです。特にインデックスの再構築や大量データの追加時には注意が必要です。

CPU使用率は、特にベクトル計算が多い場合に重要です。継続的に80%を超える場合は、スケールアップを検討します。

アラート設定のベストプラクティス

効果的なアラート設定には、以下のポイントを考慮します:

- 段階的な闾値設定: WarningとCriticalの2段階で設定し、早期対応を可能にします

- 適切な通知チャネル: 緊急度に応じてSlack、PagerDuty、メールなどを使い分けます

- ノイズの抑制: 一時的なスパイクでアラートが発生しないよう、適切な平均化期間を設定します

- ランブックの整備: アラート発生時の対応手順を明文化し、迅速な対応を可能にします

まとめ:最適な選択のために

選択フローチャート

ベクトルデータベースの選択は、以下の決定フローに従うことで、効率的に絞り込むことができます:

- プロトタイプ・検証段階 → Chromaを選択

- マネージドサービスが必須 → Pineconeを選択

- マルチモーダル検索が必要 → Weaviateを選択

- 最高性能が求められる → Qdrantを選択

- 大規模データ(10億+ベクトル) → Milvusを選択

- 既存PostgreSQL環境を活用 → pgvectorを選択

- 上記に該当しない → WeaviateまたはQdrantを検討

重要な検討事項

最終決定の前に、必ず以下の点を確認してください:

技術要件

- データ規模(現在と将3年後の予測)

- レスポンスタイム要件(P95での許容値)

- スループット要件(ピーク時QPS)

- 必須機能(フィルタリング、ハイブリッド検索等)

ビジネス要件

- 予算制約(初期費用とランニングコスト)

- 運用体制(専任エンジニアの有無)

- SLA要件(可用性、サポートレベル)

- コンプライアンス要件(データレジデンシー等)

統合要件

- 既存システムとの連携

- 開発言語とSDKの対応

- チームの技術スタックとの親和性

POCの重要性

最終的な選択の前に、必ずPOC(Proof of Concept)を実施することを強く推奨します。理論上の性能と実際のパフォーマンスは異なることが多く、実データを用いた検証が不可欠です。

POCでは以下の点を検証します:

- 実データでの検索精度

- レスポンスタイムの実測

- スケーラビリティの確認

- 運用の難易度

- コストの実測

今後の展望

ベクトルデータベース市場は急速に成長しており、今後も新しいプレイヤーの参入や既存ソリューションの機能強化が予想されます。特に以下のトレンドに注目してください:

- ハイブリッド検索の標準化: ベクトル検索とキーワード検索の統合がより一般的に

- マルチモーダル対応の拡大: テキスト、画像、音声以外のモダリティへの対応

- エッジコンピューティング対応: ローカルデバイスでのベクトル検索

- コスト効率の改善: より効率的なインデックス構造と圧縮技術

結論

ベクトルデータベースの選択は、AIアプリケーションの成功に直結する重要な意思決定です。本記事で紹介した各ソリューションにはそれぞれ特徴があり、「万能」な選択肢は存在しません。

重要なのは、自社の要件を明確にし、優先順位をつけ、適切な検証を行うことです。また、技術の進化が速い分野であるため、定期的な再評価も必要です。

ベクトルデータベースは、AI時代のデータインフラの中核として、今後もその重要性を増していくでしょう。本記事が、皆様の最適な選択の一助となれば幸いです。

関連記事

RAG実装完全ガイド:エンタープライズ向けLLMアプリケーション構築

Retrieval-Augmented Generation (RAG)の仕組みから実装まで、本番環境で使えるRAGシステムの構築方法を詳しく解説

コンテキストエンジニアリング完全ガイド:プロンプトエンジニアリングを超えた次世代AI開発

LLMアプリケーション開発の新パラダイム「コンテキストエンジニアリング」の基礎から実践まで、RAGやベクトルDBを活用した実装方法を徹底解説

AIとデータをつなぐ新たな架け橋:Model Context Protocol(MCP)が変える生成AIの未来

Anthropic社が提唱するMCPは、AIモデルと外部データの統合を標準化する革新的なプロトコル。その仕組みと可能性、そして開発者にもたらす価値を詳しく解説します。