ベクトル検索の落とし穴と効率的なRAG構築 - ハイブリッド検索による本番運用レベルのシステム設計

はじめに

検索拡張生成(RAG)システムの構築において、多くの開発者が陥る罠があります。それは「ベクトル検索さえあれば完璧」という誤解です。

この誤解は「ベクトル検索信仰」とも呼ぶべき現象で、意味的な類似性による検索が全ての問題を解決すると信じ込んでしまうことから生まれています。

実際のエンタープライズ環境でRAGシステムを運用してみると、この信仰がいかに危険かがすぐに明らかになります。

ある金融機関での実例を紹介しましょう。最新のベクトル検索技術を用いて社内規定の検索システムを構築し、デモンストレーションでは「休暇制度について教えて」といった一般的な質問に対して素晴らしい回答を生成していました。

しかし本番運用を開始すると、「規定番号HR-2024-03の内容を確認したい」「IFRS第16号の適用方法は?」といった、実務で頻繁に使用される具体的な規定番号や専門用語を含む検索で、正しい文書を取得できなかったのです。

結果として、ユーザーからの信頼を失い、システムの利用率は導入後3ヶ月で20%まで低下しました。

この失敗の根本原因は、ベクトル検索が抱える「未知の問題」にあります。埋め込みモデルの学習データに十分に含まれていない、あるいは特殊な文脈でしか使用されない単語やフレーズに対して、ベクトル検索は構造的な弱点を持っているのです。

ベクトル検索の限界を理解する

なぜベクトル検索だけでは不十分なのか

ベクトル検索の魅力は「意味で検索する」というコンセプトにあります。PineconeやWeaviateなどのベクトルデータベースは、数行のコードで実装できる手軽さも相まって、あたかも万能の解決策のように見えます。

しかし、この手軽さこそが認知バイアスを生み、本番環境での深刻な問題を見逃す原因となっているのです。

開発チームは、意味的な類似性がうまく機能する「ハッピーパス」のクエリで動作する概念実証を構築し、このシンプルなアーキテクチャが本番環境の複雑なデータにもスケールするという誤った確信を抱きがちです。

ベクトル検索が苦手とする領域は、主に3つのカテゴリーに分類されます。

第一に、固有名詞とエンティティ名です。「iPhone 15 Pro Max」のような製品名、「多摩総合医療センター」のような施設名、特定の法律条文や規定の名称などは、ベクトル空間上で他の一般的な単語と明確に区別することが困難です。

第二に、専門用語と頭字語があります。「GAN」「LLaMA」「OKR」などの業界用語や、社内でのみ通用する略語、プロジェクト名などは、埋め込みモデルの汎用的な学習データにはほとんど含まれていないため、その意味を正確に捉えることができません。

第三に、コードと識別子です。製品のSKUコード、エラーコード、APIのエンドポイント名など、意味的な類似性ではなく文字列としての完全一致が求められる情報に対して、ベクトル検索は完全一致を保証できません。

これらの要素は、エンタープライズ向けのRAGユースケースにおいて頻繁に出現します。社内規定に関する問い合わせ、特定の製品仕様に関する顧客サポート、過去の不具合報告の調査など、業務で扱われる情報の多くは、こうした固有名詞や専門用語に満ちています。

セマンティックギャップという根本的な課題

さらに深刻な問題として、「セマンティックギャップ」が存在します。これは、ユーザーの質問(クエリ)と、その答えを含む文書(パッセージ)との間に、意味的な類似性が必ずしも高くないという問題です。

例えば、「フランスの首都はどこですか?」という質問のベクトルは、「パリはフランスで最も人口の多い都市です」という答えを含む文章のベクトルと、必ずしも高い類似度を示すとは限りません。

埋め込みモデルは、質問と答えの間に存在する推論的なつながりを捉えることに失敗する可能性があり、結果として正解を含む文書を見逃してしまうのです。

ベクトル埋め込みは対照的な情報の区別も苦手とします。「私はリンゴが好きです」と「私はかつてリンゴが好きでした」という二つの文は、多くの共通する単語を含んでいるため、ベクトル空間上では非常に近い位置に配置される可能性があります。

しかし、その意味合いは正反対です。このようなニュアンスを区別できない場合、検索システムは文脈的に誤った情報を取得し、LLMに渡してしまうリスクがあります。

技術的な制約:チャンキングと次元の呪い

チャンキングの問題も見逃せません。RAGでは、長文のドキュメントをLLMのコンテキストウィンドウに収まるように、より小さな「チャンク」に分割する必要があります。

しかし、この分割プロセスが機械的・固定的である場合、文章の文脈が破壊されるという深刻な問題を引き起こします。

例えば、あるチャンクが「彼らは」という代名詞で始まっていても、その指示対象が前のチャンクに含まれている場合、そのチャンクは単体では意味をなさなくなります。

このような文脈が失われたチャンクは、埋め込みモデルによって不正確なベクトルとして表現され、最終的にLLMに渡されても有効な情報として機能しません。

さらに、ベクトル埋め込みは数百から数千の次元を持つ高次元空間で表現されるため、「次元の呪い」として知られる現象に直面します。

高次元空間では、データ点間の距離が均一化しやすくなり、意味のあるパターンや類似性を見つけることが困難になり、結果として検索精度が低下する可能性があります。

検索システムの性能評価において重要な精度と再現率のトレードオフも、ベクトル検索の限界を示しています。

ベクトル検索は概念的に関連する可能性のある文書を幅広く見つけ出す能力に優れており、高い再現率を実現します。しかし、その代償として精度が犠牲になることが多く、「広い網を投げる」アプローチに似ています。

多くの関連文書を捉える一方で、無関係な情報も一緒に引き上げてしまう傾向があるのです。

この低精度な検索結果がLLMのコンテキストとして提供されると、「Garbage in, garbage out」という問題が顕在化し、不正確または無関係な情報がコンテキストに含まれることで、LLMは誤った応答を生成したり、ハルシネーションを引き起こしたりする可能性が高まります。

ハイブリッド検索による解決

レキシカル検索の再評価

こうしたベクトル検索の限界に対して、古くから情報検索の基盤を支えてきたレキシカル検索(キーワード検索)の価値が再評価されています。

レキシカル検索は、時代遅れの技術ではなく、現代の高度な検索スタックにおいて不可欠な補完的要素として機能します。

レキシカル検索の代表的なアルゴリズムであるBM25は、文書とクエリに含まれる単語の統計的な一致に基づいて関連性を評価します。

BM25は、Term Frequency(特定の文書内でクエリに含まれる単語がどれくらいの頻度で出現するか)、Inverse Document Frequency(その単語が文書全体の中でどれだけ希少か)、Document Length(文書の長さの正規化)という3つの要素を組み合わせてスコアを算出します。

このアルゴリズムの核心は、「文書全体では希少だが、特定の文書内では頻繁に出現する単語」に高いスコアを与える点にあります。この特性により、BM25は特定のキーワードやフレーズに非常に高い精度でヒットする能力を持ちます。

レキシカル検索が圧倒的な優位性を発揮するシナリオは数多くあります。

エラーコードの検索では「ERROR_DB_CONNECTION_TIMEOUT」のような文字列の完全一致が必要です。法律条文の参照では「民法第709条」という正確な条文番号が重要となります。

製品型番の確認では「XR-500-JP-2024」のような一意の識別子を正確に見つける必要があり、医薬品名の検索では「アセチルサリチル酸」のような専門用語を確実に特定しなければなりません。

これらは全て、エンタープライズ環境では頻繁に発生する検索ニーズです。ベクトル検索では曖昧な結果しか得られない場合でも、レキシカル検索なら確実に目的の文書を見つけ出すことができます。

一方で、レキシカル検索にも明確な限界が存在します。最大の弱点は、言葉の表面的な一致にしか依存できない点です。

ユーザーが「家」と検索した場合、レキシカル検索は「住居」や「邸宅」といった同義語を含む文書を見つけることができません。意味的な関連性を理解できないため、ユーザーが使用した単語と完全に一致する文書しか検索対象になりません。

また、単語の意味は文脈によって変化しますが、レキシカル検索はこの文脈を考慮しません。さらに、ユーザーが何を求めているか明確でない、曖昧な自然言語の質問に対して、適切なキーワードを抽出して検索することが困難です。

これらの限界は、まさにベクトル検索が得意とする領域です。したがって、最高の検索体験を提供するためには、両者の長所を組み合わせ、短所を補い合うアプローチが論理的な帰結となります。これが「ハイブリッド検索」です。

ハイブリッド検索のアーキテクチャ

ハイブリッド検索は、二つ以上の異なる検索手法を一つのクエリパイプラインに統合する技術です。最も一般的な組み合わせは、レキシカル検索(スパースベクトル検索とも呼ばれる)とセマンティック検索(デンスベクトル検索)です。その目的は、キーワードの一致を重視するレキシカル検索の精度と、文脈や意図を理解するセマンティック検索の柔軟性を同時に活用することにあります。例えば、「アラスカのタラを釣る方法」というクエリに対し、ベクトル検索は「釣る」という単語を「魚釣り」の文脈で理解し、レキシカル検索は「アラスカのタラ」という固有名詞を正確に捉えます。ハイブリッド検索は、これら両方のシグナルを統合し、どちらか一方の手法だけでは見逃してしまう可能性のある、最も関連性の高い文書を提示します。

ハイブリッド検索の実装には、主に二つのアーキテクチャパターンが存在します。並列実行パターンは最も一般的で直感的なアプローチで、ユーザーからのクエリを受け取ると、システムはレキシカル検索とベクトル検索を同時に実行します。それぞれの検索エンジンが独立して候補となる文書のリストとスコアを生成し、その後、融合ステップでこれらの結果を一つのランキングに統合します。段階的実行パターンは逐次的なアプローチで、まず計算コストが比較的低いレキシカル検索を用いて、大規模な文書コーパスから関連性の高い候補を広範に絞り込み、次にこの絞り込まれた候補セットに対してのみ、計算コストが高いベクトル検索やリランキングモデルを適用します。

Reciprocal Rank Fusion(RRF)による賢い統合

ハイブリッド検索の核心部分は、異なる性質を持つ検索結果をいかにして賢く統合するかという点にあります。BM25のスコアは上限がなく、文書コーパスの統計的性質に依存する一方、ベクトル検索で一般的に用いられるコサイン類似度のスコアは-1から1の間に正規化されています。これらの異なるスケールのスコアを直接比較することは困難であり、単純な加重平均では一方のスコアが他方を圧倒してしまう可能性があります。

この課題を解決するために広く採用されているのが、Reciprocal Rank Fusion(RRF)というアルゴリズムです。RRFの最大の特徴は、各検索結果のスコアではなく順位(ランク)に基づいて統合を行う点です。これにより、異なる検索システム間のスコアのスケールや分布の違いに影響されにくい、頑健な融合が可能になります。

RRFのスコア計算は、各文書に対して、それぞれの検索結果リストにおける順位の逆数を足し合わせることで行われます。例えば、ある文書がBM25で1位、ベクトル検索で3位だった場合と、別の文書が両方で2位だった場合を比較すると、後者の方が両方の検索手法から安定して高い評価を受けているとみなされ、より高いRRFスコアを得ることがあります。このように、RRFは複数の検索手法からの「合意」を重視し、より信頼性の高いランキングを生成します。

RRFの採用は、業界における重要なトレンドを示唆しています。初期のハイブリッドシステムは、異なるスコアを正規化して組み合わせるための複雑で独自仕様のロジックに苦慮していました。しかし、RRFのようなシンプルで、スコアに依存せず、説明可能な集計手法が登場したことで、状況は変わりました。Azure AI Search、Elasticsearch、Weaviateといった主要なプラットフォームがRRFを標準的な融合手法として採用したことで、ハイブリッド検索の実装はもはや特殊で困難な技術ではなくなりました。

さらなる精度向上:リランキングの活用

二段階検索パラダイム

ハイブリッド検索で取得した結果をさらに改善する方法として、「リランキング」があります。リランキングは、検索プロセスを二段階に分けるアーキテクチャに基づいています。第一段階のリトリーバーでは、ハイブリッド検索を用いて大規模な文書コーパスから関連性の高い候補文書を幅広く取得します。この段階では再現率の最大化が目的となり、できるだけ多くの関連文書を網羅的に集めることに重点を置きます。第二段階のリランカーでは、第一段階で取得した少数の候補文書セットに対して、より計算コストは高いが精度の高いCross-Encoderモデルを適用します。

Cross-EncoderとBi-Encoderの違い

Cross-Encoderは、通常のベクトル検索で使用されるBi-Encoderとは根本的に異なる仕組みを持っています。Bi-Encoderではクエリと文書がそれぞれ独立してエンコードされ、別々のベクトルが生成されます。検索時には、事前に計算された文書ベクトルと、実行時に計算されたクエリベクトルの類似度を比較します。この方法は文書ベクトルを事前に計算・インデックス化できるため非常に高速ですが、クエリと文書の相互作用を捉える能力には限界があります。

一方、Cross-Encoderはクエリと一つの文書をペアとしてモデルに同時に入力します。モデル内部のTransformerアーキテクチャが、クエリと文書の両方の単語間に双方向の注意(Attention)を計算し、文脈的な関連性を深く分析します。その結果、単一の関連度スコアが出力されます。このアプローチは、クエリと文書の微妙なニュアンスや意味的な関係性を非常に高い精度で捉えることができますが、クエリごとに各候補文書とのペアで推論を実行する必要があるため、計算コストが非常に高く、処理速度も遅くなります。

リランキングの経済的価値

リランキングは検索ステップに追加のレイテンシと計算コストを発生させますが、驚くべきことに、RAGパイプライン全体のコストを削減する効果をもたらす可能性があります。その理由は、RAGシステムにおける最もコストがかかる部分が、多くの場合LLMの推論だからです。LLMの利用料金は、入力されるトークン数に比例して増加します。リランキングによって、より少数で、かつより関連性の高い文書だけをLLMのコンテキストとして提供できれば、プロンプト全体のトークン数を大幅に削減できます。ある分析では、同量のテキストを処理する場合、LLMのコストはリランキングモデルの約75倍に達すると報告されています。この経済的なトレードオフを考慮すると、リランキングは単なる精度向上のための追加機能ではなく、システム全体のコストパフォーマンスを最適化するための戦略的な投資と見なすことができます。

本番環境での実装戦略

プラットフォーム選定の重要性

本番環境でのRAGシステム構築において、技術選定は極めて重要です。市場は、単機能のベクトルストアと、ベクトルをデータタイプの一つとして扱う包括的な「検索プラットフォーム」に二極化しつつあり、後者がエンタープライズRAGにとってはより堅牢で将来性のある選択肢となっています。初期の市場は、ANN検索という一つの機能に特化した専門的なベクトルデータベースが注目を集めました。しかし、ベクトル検索のみの限界が明らかになるにつれて、ElasticsearchやMicrosoftのような既存の検索技術の巨人が、自社の機能豊富なプラットフォームにベクトル検索機能を統合し始めました。これらのプラットフォームは、既にレキシカル検索、フィルタリング、ファセット、セキュリティトリミング、スケーラビリティといったエンタープライズ向けの成熟した機能を持っており、ベクトル機能は既存のエコシステムへの拡張として追加されました。

データ前処理とチャンキング戦略

高品質な検索結果を得るためには、検索対象となるデータの質が決定的に重要です。単純な固定サイズでのチャンキングは文脈の喪失を引き起こすため、より洗練された戦略が求められます。文章の構造を考慮した手法として、文や段落の区切りを尊重する再帰的チャンキングや、財務報告書のような構造化された文書において、表やセクション全体を一つのチャンクとして維持する要素ベースのチャンキングなどがあります。また、各チャンクに豊富なメタデータ(文書のタイトル、作成日、著者、カテゴリなど)を付与し、検索時にフィルタリングやスコアのブースティングに利用することが非常に重要です。

継続的な評価と改善

RAGシステムの性能を継続的に改善するためには、体系的な評価とチューニングが不可欠です。RAGBenchやLegalBench-RAGのような標準的なベンチマークを使用してシステムの性能を客観的に測定し、A/Bテストを通じて異なるパラメータ設定やアルゴリズムの実際の効果を検証します。また、本番環境にデプロイした後は、ユーザーからのフィードバックを収集し、検索戦略を動的に調整するフィードバックループを実装することが、システムの品質を長期的に維持・向上させる上で極めて重要です。

RAG成熟度モデル

RAGシステムの構築は、一度きりの作業ではなく、継続的な改善を伴う進化のプロセスです。成熟度モデルとして整理すると、レベル1のナイーブRAG(ベクトル検索のみ)は実装が簡単でプロトタイピングには最適ですが、本番環境での信頼性に欠けます。レベル2の堅牢なRAG(ハイブリッド検索)は、本番運用に耐える信頼性を持ち、多くのエンタープライズアプリケーションに適用可能です。レベル3の高度なRAG(ハイブリッド検索+リランキング)は、Cross-Encoderを用いたリランキングにより、ミッションクリティカルなシステムに必要な最高レベルの精度を実現します。レベル4の能動的なRAG(クエリ拡張を含む)は、Multi-Query拡張やHyDEといった手法を用いて、入力クエリ自体を最適化し、ユーザーの意図を深く理解します。

まとめ

本記事で解説したように、本番環境で信頼性の高いRAGシステムを構築するためには、ベクトル検索だけでは不十分です。ハイブリッド検索は、もはや「オプション」ではなく「必須要件」として認識すべきです。

ベクトル検索の限界を理解することが第一歩です。固有名詞や専門用語への対応が困難という構造的な問題は、エンタープライズ環境では致命的な欠陥となります。セマンティックギャップ、チャンキング問題、次元の呪いといった技術的な課題も、単純なベクトル検索アプローチの限界を示しています。

一方で、レキシカル検索の価値を再認識する必要があります。BM25のような古典的手法は、キーワードの完全一致において今でも無敵の強さを誇ります。エラーコード、法律条文、製品番号などの検索において、レキシカル検索は不可欠な要素です。

ハイブリッド検索を標準とすることで、両者の長所を最大限に活用できます。RRFによる賢い統合は、異なる性質を持つ検索結果を効果的に組み合わせ、精度と再現率のバランスを実現します。さらに、Cross-Encoderによるリランキングを追加することで、LLMに渡すコンテキストの質を劇的に向上させることができます。コスト効率の観点からも、リランキングによるトークン数の削減は、全体的なシステムコストの最適化につながります。

RAGシステムの進化の方向性は、単なる情報の「検索」から、より深い「理解」と「推論」へと向かっています。GraphRAGによるナレッジグラフの統合、マルチモーダル検索、自律的なエージェントRAGシステムなど、次世代の技術も登場し始めています。しかし、これらの高度な技術も、堅牢な検索基盤の上に構築されなければ、その真価を発揮することはできません。

エンタープライズ環境でRAGシステムを成功させるには、技術的な深い理解と、実践的なアプローチの両方が必要です。ベクトル検索信仰から脱却し、ハイブリッド検索を基盤とした堅牢なアーキテクチャを構築することで、真に役立つAIシステムを実現できるでしょう。RAGシステムの構築は、単なる技術的な課題ではなく、ビジネス価値を生み出すための戦略的な取り組みです。適切な技術選択と継続的な改善により、組織の知識を最大限に活用し、競争優位性を生み出すシステムを構築することができるのです。

関連記事

コンテキストエンジニアリング完全ガイド:プロンプトエンジニアリングを超えた次世代AI開発

LLMアプリケーション開発の新パラダイム「コンテキストエンジニアリング」の基礎から実践まで、RAGやベクトルDBを活用した実装方法を徹底解説

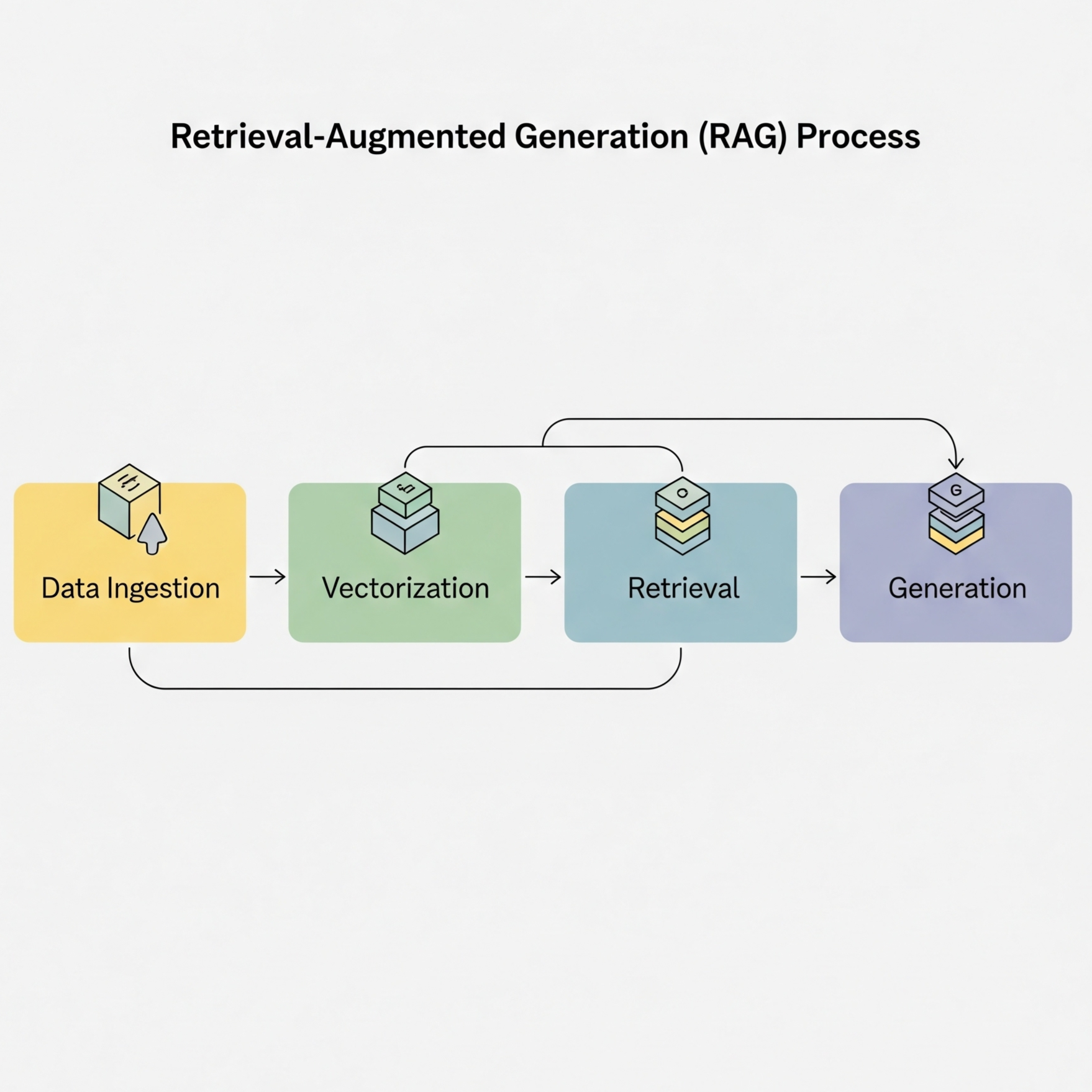

RAG実装完全ガイド:エンタープライズ向けLLMアプリケーション構築

Retrieval-Augmented Generation (RAG)の仕組みから実装まで、本番環境で使えるRAGシステムの構築方法を詳しく解説

AIとデータをつなぐ新たな架け橋:Model Context Protocol(MCP)が変える生成AIの未来

Anthropic社が提唱するMCPは、AIモデルと外部データの統合を標準化する革新的なプロトコル。その仕組みと可能性、そして開発者にもたらす価値を詳しく解説します。